Honderden rankingfactoren bepalen het succes van je website in de zoekresultaten van Google & Co. Een SEO-audit helpt je om de zwakke punten van je website op te sporen, zodat je gerichte tegenmaatregelen kunt initiëren. We leggen stap voor stap uit hoe de SEO-audit werkt en welke tools je nodig hebt. Je kunt hier ook de hele gids als e-book downloaden.

Wat is een SEO audit?

Een SEO audit is de ultieme test van je website om het huidige niveau van zoekmachineoptimalisatie en technische optimalisatie te beoordelen. Grofweg worden alle on-page en off-page factoren van je website of webshop tot in de kleinste details gecontroleerd.

SEO-experts gebruiken checklists, online tools en hun eigen ervaring om de inhoud, structuur en prestaties van je website te evalueren. Maar inhoud en backlinks moeten ook een aantal tests doorstaan. De focus van een SEO audit ligt dan ook op het evalueren van de zoekmachinevriendelijkheid van je website.

In de regel wordt hieruit een catalogus van maatregelen ontwikkeld. Deze catalogus bevat alle zwakke punten en potentiële kansen van je website. Als je besluit om de problemen niet door een SEO-bureau te laten verhelpen, heb je nog altijd de mogelijkheid om zelf individuele maatregelen uit de catalogus uit te voeren. Maar SEO audits zijn ook een kans voor bureaus om:

- Het dienstverleningsportfolio uit te breiden

- Klanten te overtuigen van technische en inhoudelijke maatregelen

- Potentiële klanten te informeren over de toestand van een website

Een SEO audit is de basis voor je strategie voor de komende maanden. Met een SEO audit kun je de zwakke punten van je website identificeren en deze vervolgens gericht opschonen.

De juiste inhoud als basis

Het gaat zeker niet alleen om de technische optimalisatie van je website. Je content moet ook kloppen en aansluiten bij je doelgroep, zodat je gevonden kunt worden door Google en andere zoekmachines. Bekijk de tips in ons e-book Content Marketing voor bureaus en freelancers.

Deze tools heb je nodig

Om een SEO audit holistisch te laten zijn, moet je ervoor zorgen dat je toegang hebt tot de belangrijkste analyse-tools en -diensten. Deze omvatten Matomo (een privacy-geoptimaliseerd alternatief voor Google Analytics), Google Analytics zelf, de Google Search Console en toegang tot je Google My Business vermelding.

Hoe meer gegevens beschikbaar zijn, hoe groter de kans dat je inconsistenties tot op de bodem kunt uitzoeken. De analyseperiode moet ten minste de laatste zes maanden of de laatste twaalf maanden omvatten.

Waar is Matomo of Google Analytics voor?

Met diensten als Matomo of Google Analytics kun je het gebruikersgedrag en de oproepen naar je website buiten de organische zoekopdrachten om evalueren. Je krijgt een overzicht van hoe mensen omgaan met je website en vanuit welke bronnen de gebruikers toegang hebben tot je website.

Waar is de Google Search Console voor?

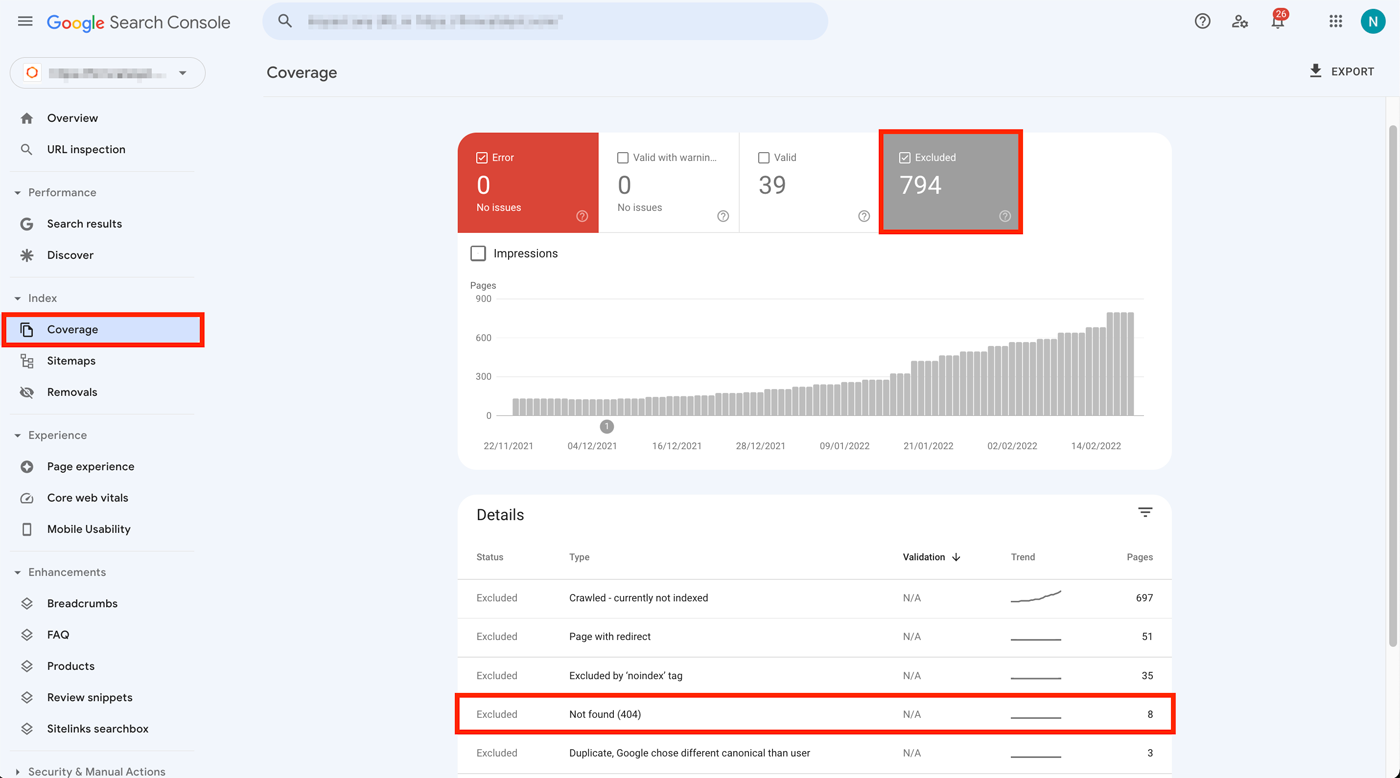

Search Console geeft informatie over hoe je website presteert in de zoekresultaten. Je wordt ook op de hoogte gebracht van 404-fouten en technische problemen (bijv. onjuiste gestructureerde gegevens).

Meer gegevens uit de Search Console

Voor pure website hits in de zoekresultaten zijn de gegevens van Search Console beter geschikt dan die van Google Analytics. Google Analytics mag alleen privacy-conform als opt-in worden gebruikt, wat betekent dat een bepaald deel van de bezoekers niet door Google Analytics kan worden vastgelegd.

Worden betaalde tools aanbevolen?

Ja en nee. Verschillende SEO-tools vervullen verschillende doelen. Sommige zijn geschikt om je backlinks te evalueren, terwijl andere zich richten op de inhoud of de technische staat van je website.

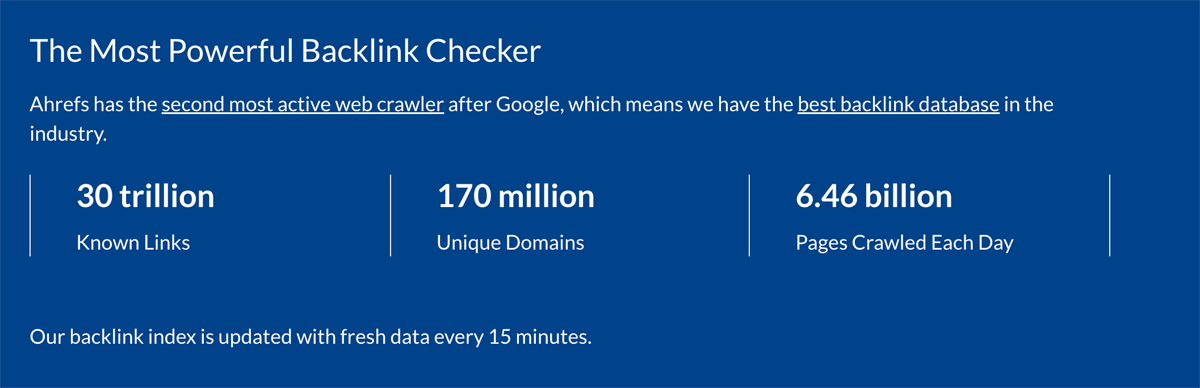

De meeste betaalde SEO tools hebben een enorm voordeel ten opzichte van hun gratis concurrenten: ze hebben veel grotere hoeveelheden gegevens en kunnen aanzienlijk meer informatie over trefwoorden en backlinks weergeven. De gegevens zijn ook vaak tot op de dag nauwkeurig.

Gratis SEO-tools zijn vaak beperkt, de gegevens zijn niet up-to-date of beperkt in hun suggesties, omdat dagelijkse, miljoenvoudige zoekopdrachten en de bijbehorende opslag uiteindelijk ook kosten veroorzaken. Goede alles-in-één oplossingen voor een SEO audit zijn tools zoals:

- Semrush (vanaf €99,95/maand)

- Ahrefs (vanaf $99/maand)

- Sistrix (Optimizer Modul) (vanaf €99/maand)

- Ryte (vanaf €99/maand)

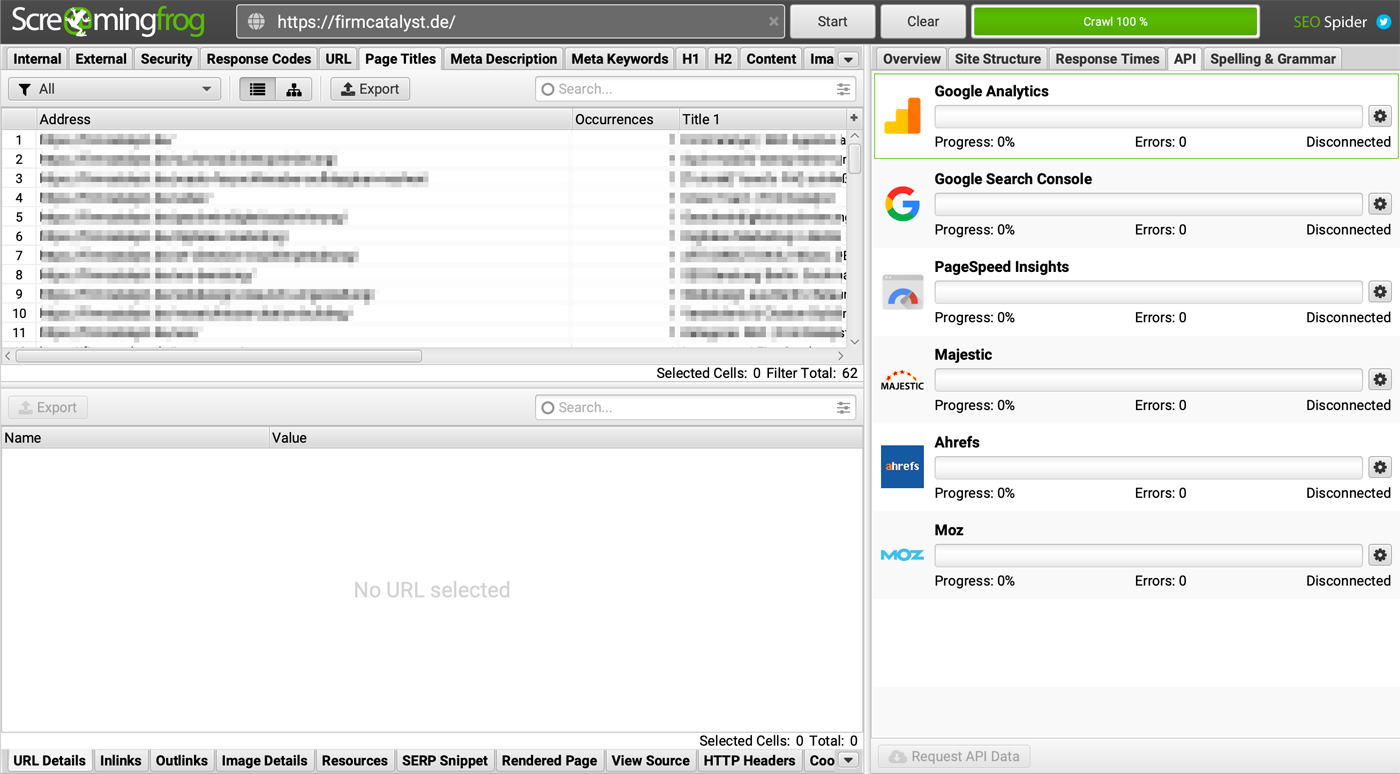

Een technische audit en crawlability check kun je het beste uitvoeren met tools als de "Screaming Frog Spider". Backlink audits daarentegen worden uitgevoerd met tools als Ahrefs, Majestic of Semrush. Hier heb je echter extra kennis nodig over linkbuilding en linkkwaliteit om onderscheid te kunnen maken tussen schadelijke en goede links.

Gratis SEO tools: Screaming Frog Spider

Als het gaat om de technische evaluatie van je website, is de Screaming Frog Spider de standaard in de SEO industrie. De tool is echter vooral bedoeld voor gevorderde gebruikers. Het goede nieuws is dat het programma momenteel gratis is voor maximaal 500 gecrawlde URL's. Dat is genoeg voor de meeste kleine webagentschappen, bedrijven en blogs.

Nog een verschil met de hierboven genoemde tools: de Screaming Frog Spider is een uitvoerbaar programma en verandert je werkapparaat in een crawler. Diensten zoals Google Data Studio, de Search Console of Pagespeed Insights kunnen ook via extensies worden gekoppeld.

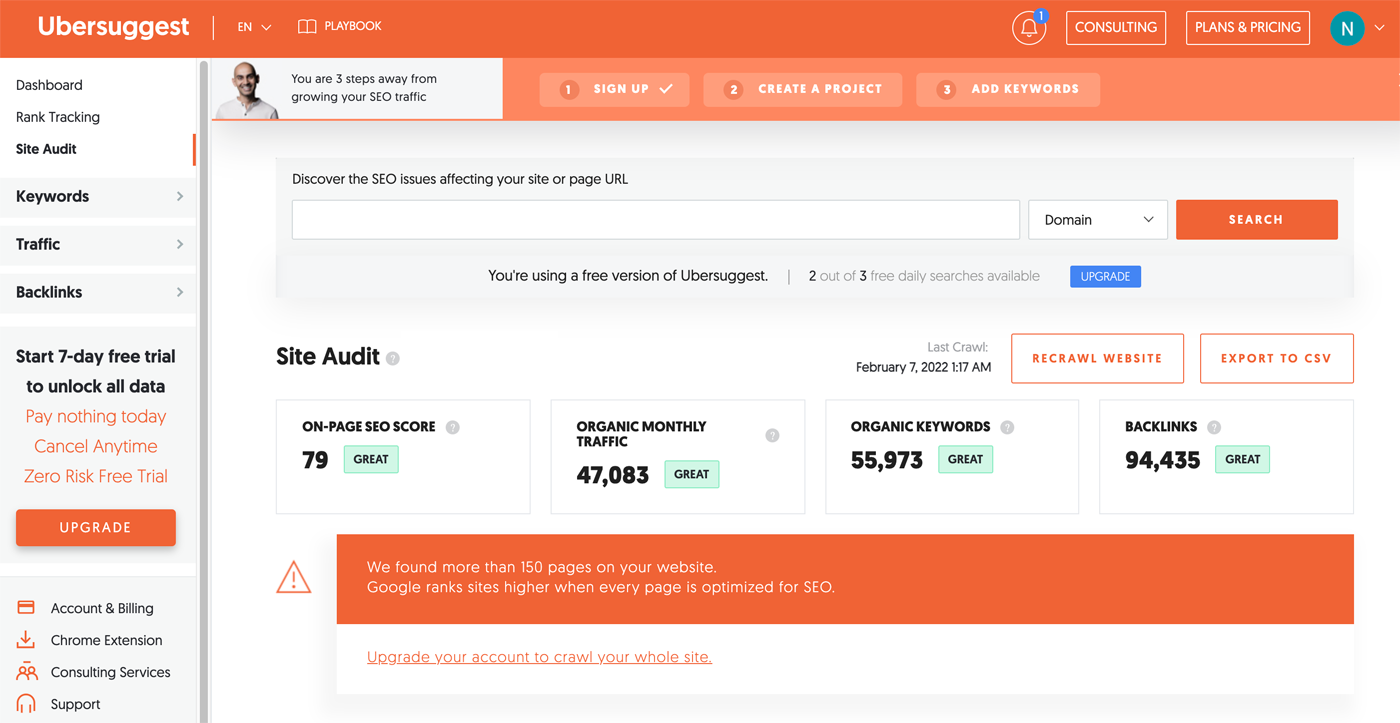

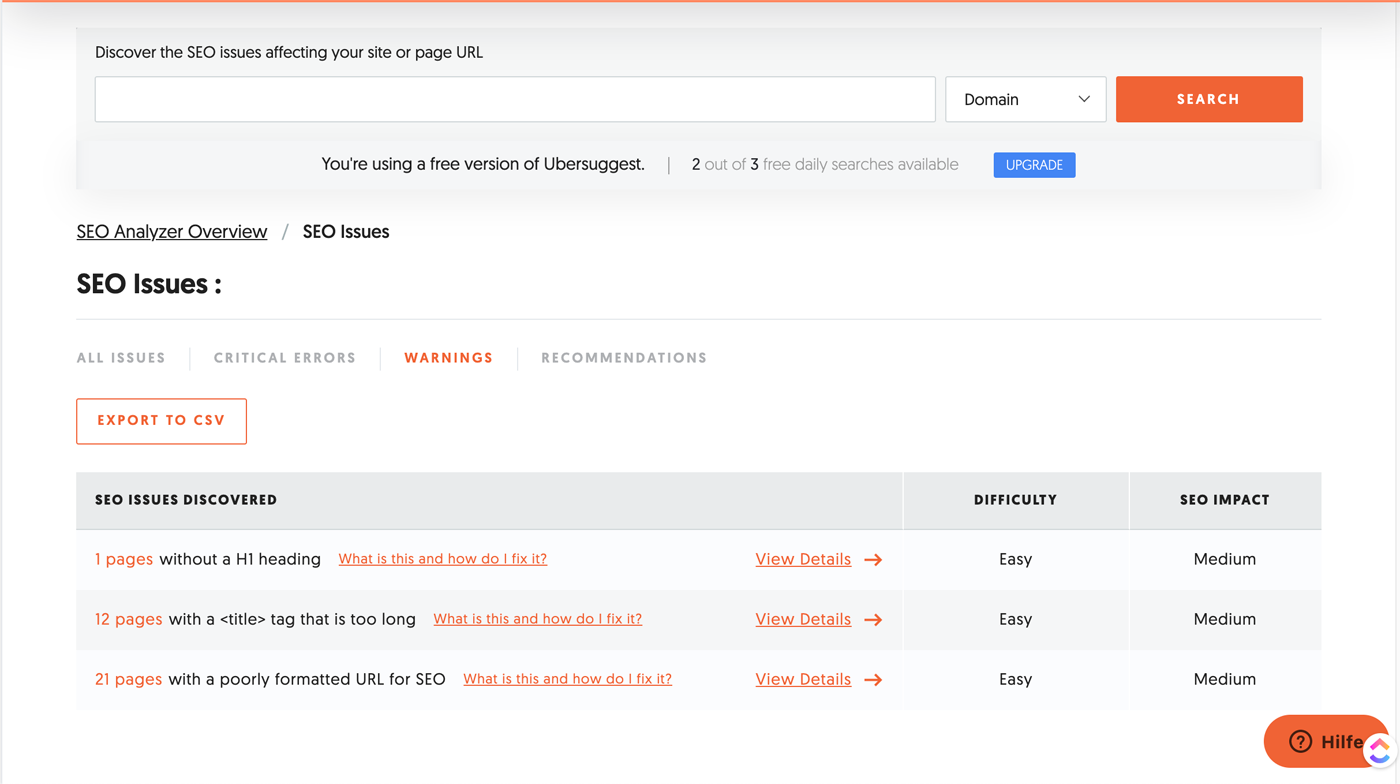

Neil Patels Site Audit

Neil Patel's Page Audit (onderdeel van de SEO tool "Ubersuggest") biedt in de gratis versie de mogelijkheid om 150 URL's te laten beoordelen of om 3 zoekopdrachten per dag uit te voeren. Opmerking: de tool kan de bovenstaande hulpmiddelen bij lange na niet bijhouden in de hoeveelheid tests.

De ernstigste fouten van een website worden echter op betrouwbare wijze getest. En dat maakt de SEO tool van Neil Patel de moeite waard voor de meeste kleine bedrijven of blogs.

Gegevens van de gratis Google-diensten

Mijn tip: Intussen zijn diensten als Google's Search Console zo verbeterd dat een uitgebreide SEO-audit al kan worden uitgevoerd via het gratis Google-productaanbod.

Veel van de hierboven genoemde SEO tools hebben gratis versies. Het aantal resultaten in elke tool is echter beperkt. Als je geen budget hebt voor betaald gebruik, raad ik je aan veel gratis tools te combineren, zodat je ondanks de beperkte gegevens toch zoveel mogelijk fouten kunt vinden.

SEO audit: de opbouw

Een SEO audit kan worden onderverdeeld in verschillende categorieën. Sommige aanbevelingen worden direct op je WordPress website geïmplementeerd (crawlability, snelheid, enz.) terwijl andere optimalisaties (backlinks, webhosting, enz.) buiten je webpagina's worden uitgevoerd. Voor elke aanbeveling link ik naar een geschikte bron die jou kan helpen om het probleem zelf op te lossen.

Crawlabiliteit & SEO

Het doel is na te gaan of alle inhoud van je website kan worden gevonden, welke delen van je webpagina's opzettelijk worden uitgesloten en hoe je website in de zoekresultaten wordt weergegeven. Bovendien controleren wij welke informatie niet meer toegankelijk is voor zoekmachines. Evenzo, of de inhoud zich houdt aan een semantische structuur. Met andere woorden, of de structuur van je website begrijpelijk is voor zoekmachines.

- Tools: Search Console, site audit tools (Semrush, Screaming Frog Spider enz.)

- Moeilijkheidsgraad: gemakkelijk

Belangrijke criteria voor indexeerbaarheid zijn:

- Je website kan alleen worden geopend via https, de http://-versie verwijst je door.

- Een geldig SSL-certificaat is geactiveerd.

- Alle inhoud en links hebben een beveiligde verbinding (https:// in plaats van http://), lees mixed content. Of raadpleeg deze tutorial.

- Alle pagina's hebben een unieke title-tag. De title-tag is anders dan de H1-titel (over-optimalisatie).

- Elke pagina heeft maar één H1 titel. Dubbele H1-koppen moeten worden verwijderd.

- Alle pagina's hebben een uitnodigende en unieke metabeschrijving. Metabeschrijvingen kunnen worden gewijzigd, bijvoorbeeld via Yoast SEO.

- Er zijn geen 404-pagina's (niet gevonden), aangezien de overeenkomstige URL's correct worden doorverwezen.

- Er zijn geen links die naar 404-pagina's leiden (zowel interne als externe links).

- Belangrijke pagina's worden niet uitgesloten van crawling. Instructies hiervoor: Noindex in Yoast SEO configureren.

De volgende criteria zijn even belangrijk:

- De robots.txt is geldig en bevat slechts zoveel instructies als werkelijk nodig zijn. Instructies: robots.txt uitgelegd door Semrush. Tip: Yoast SEO kan een robots.txt voor jou maken.

- Je sitemap is gelinkt in de robots.txt.

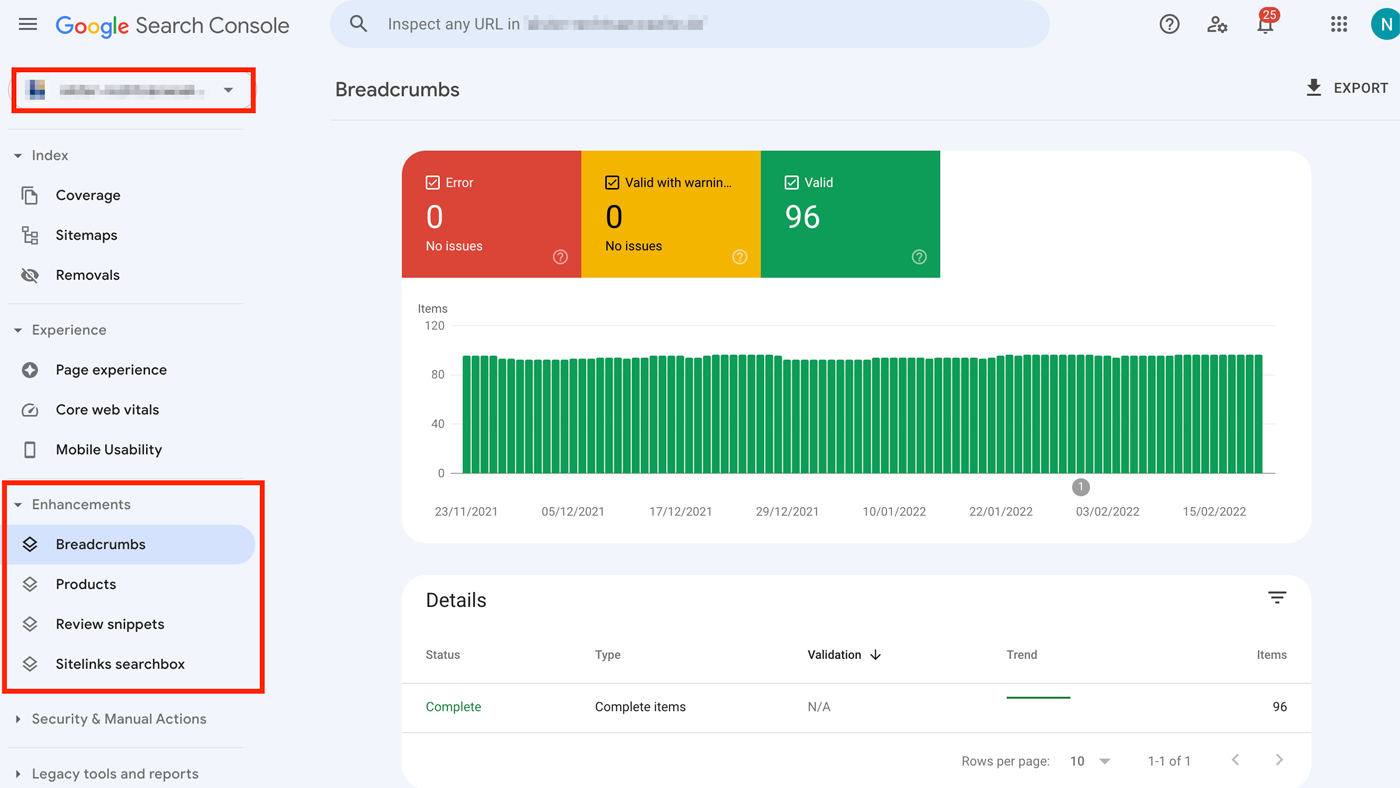

- Als rich snippets, FAQ's of andere schema functies worden gebruikt op de website, dan moeten deze regelmatig worden getest in de schema markup testing tool of in de Search Console.

- Alle interne links gebruiken het dofollow-attribuut.

- Je afbeeldingen hebben Alt-tags (zie de instructies voor beeldoptimalisatie).

- Er zijn nauwelijks forwarding- of redirect chains.

- URL's zijn kort en bevatten het trefwoord waarvoor je wilt scoren. Stopwoorden in de URL's worden vermeden.

- URL's gebruiken koppeltekens en geen laag streepje (underscores). Koppeltekens worden gebruikt om woorden te scheiden.

- In het beste geval kan alle inhoud met 3 klikken worden bereikt.

Bovendien worden ongebruikte post types, taxonomieën en categorieën (bijv. gegenereerd door WordPress themes of plugins) uit de zoekresultaten geweerd om crawl budget te besparen. Dit is mogelijk met Yoast SEO, zie deze tutorial over de juiste instellingen.

Dit alles kan oneindig worden uitgebreid. Zeer specifieke onderwerpen zoals href-lang tags, AMP of canonicals zijn opzettelijk weggelaten uit deze lijst om de complexiteit niet nog groter te maken. Je kunt deze onderwerpen behandelen zodra alle andere onderdelen van de SEO-audit zijn doorgewerkt.

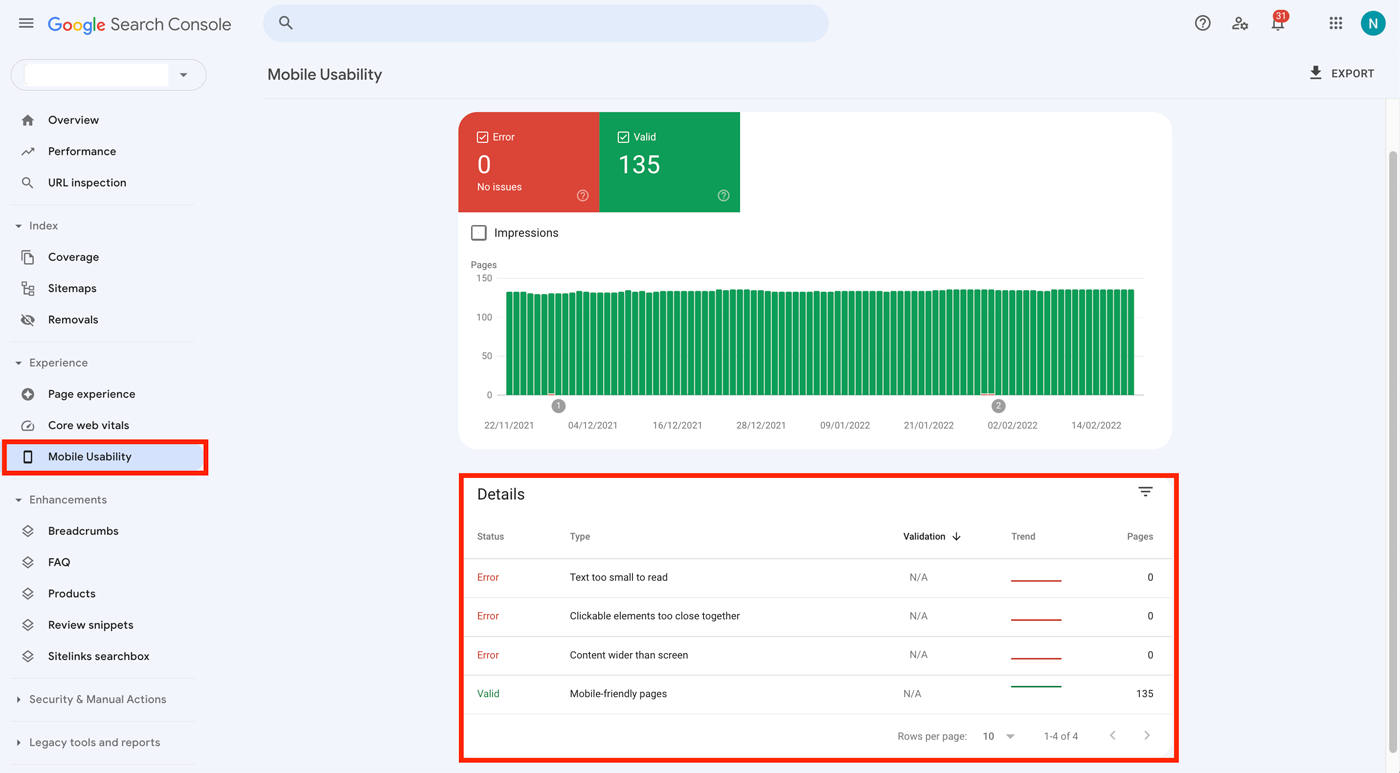

Weergave op mobiele apparaten

Aangezien Google de zoekresultaten opsplitst in twee verschillende indices (mobiel en desktop) – en dus zowel de mobiele weergave als de desktopweergave van je website apart beoordeelt – moet de mobiele weergave van je website ook foutloos zijn. Zelfs in 2022 en in tijden van mobile first, waarbij mobiele bezoekers van een website vaak zo'n 70 procent uitmaken, ligt de focus van veel ontwikkelaars en webdesigners nog steeds op de desktopversie.

Het resultaat is een slechte positie in de mobiele zoekresultaten, minder traffic en een verlies van potentiële klanten. In de B2B-sector zijn desktopbezoeken echter vaak nog steeds superieur aan mobiele aanvragen.

- Tools: Search Console, de ontwikkelaarstools van je browser, Google Lighthouse of je mobiele apparaat.

- Moeilijkheidsgraad: gemiddeld

Fouten opsporen in de mobiele weergave

Jouw doel moet zijn om alle weergavefouten op de mobiele versie van je website te herstellen. Het is van het grootste belang dat je fouten in de weergave herstelt, zoals inhoud die niet in een beeldscherm past of die overlapt. Je moet vermijden dat je inhoud verbergt op de mobiele versie van je website, maar wel toont op de desktopversie. Dit komt omdat de mobiele versie waarschijnlijk aan de meeste gebruikers zal worden weergegeven en de belangrijkste versie is die door Google wordt gebruikt om je inhoud en ranking te bepalen.

Je kunt alle url's en elementen van je website testen op je eigen mobiele apparaat. Het risico bestaat echter dat de versie van de website voor andere apparaatformaten of schermresoluties nog steeds onjuist wordt weergegeven.

Variant 1: Analyseer waarschuwingen uit de Search Console

Gelukkig informeert Google ons over kritieke weergavefouten rechtstreeks in de Google Search Console:

Het probleem met deze methode is dat alleen kritieke fouten worden gemeld. Elementen die niet aanklikbaar zijn of niet zijn aangepast aan de UX worden niet herkend en gerapporteerd.

Variant 2: Gebruik browserontwikkelaarstools

Een andere mogelijkheid wordt door de meeste webbrowsers geboden in de ontwikkelaarsconsole. Daar kunnen we de weergave op andere toestellen simuleren. Oliver Pfeil heeft hierover een artikel geschreven op wp unboxed: Responsive web design voor mobiel gebruik – dit is hoe mobiele optimalisatie werkt. Hier vind je meer informatie over de methode:

Technische problemen en snelheid

Iedereen die de ontwikkeling van SEO in de afgelopen 10 jaar heeft gevolgd, herinnert zich apocalyps-scenario's als Mobilegeddon. Aankondigingen die de hele SEO scène in opschudding hebben gebracht. Het Mobilegeddon heeft niet plaatsgevonden... het is echter geen geheim dat Google al jaren veel moeite doet om websites sneller te maken op het web. Tegelijkertijd moedigt Google webmasters aan om de Google-index niet te overspoelen met pagina's van lage kwaliteit.

De snelheid waarmee een site volledig wordt geladen, is een belangrijke rankingfactor geworden. En Google heeft verschillende gratis tools gelanceerd om ontwikkelaars te helpen om hun eigen laadtijden te optimaliseren. Aangezien de laadtijd van invloed is op de gebruikerservaring van je webpagina's, hebben laadtijden een passief effect op de beoordeling van het gebruikersgedrag. Vooral de verkoop van e-commerce heeft te lijden onder trage laadtijden, zoals Amazon in een studie bekend heeft gemaakt.

Het optimaliseren van de snelheid van een website is een kunst op zich, waar veel ontwikkelaars niet graag mee bezig zijn. Problemen oplossen is tenslotte tijdrovend. Maar zelfs zonder experts aan je zijde, zijn er een paar tools die je kunt gebruiken om de snelheid van je WordPress website snel te verbeteren. Bekijk de 10 belangrijkste maatregelen voor je WordPress performance.

Een andere tip is om te kiezen voor een gespecialiseerde WordPress hosting. Raidboxes heeft zich met zijn premium WordPress hosting gespecialiseerd in snelle laadtijden. Het is niet belangrijk om met elke website een score van 100/100 te halen in Google PageSpeed. De url's die de grootste rol spelen in het succes van je bedrijf moeten echter de kortst mogelijke laadtijden hebben:

- Landingpages

- Service pagina's

- Winkelmandjes en productpagina's

Tools zoals GTmetrix en Pagespeed Insights geven je snel aanbevelingen over hoe je je websites kunt optimaliseren.

Hoewel de door PageSpeed Insights verstrekte waarden een goede indicator zijn, verschaffen zij geen informatie over de werkelijke laadtijd, zoals in dit e-book nader wordt beschreven.

- Tools: GTmetrix, Pagespeed Insights, Google Lighthouse, Search Console

- Moeilijkheidsgraad: moeilijk

Hier zijn enkele tips over hoe je de snelheid van je WordPress websites kunt verhogen:

- Een snelle oproep van je WordPress website. Het kerngetal TTFB (time to first byte) moet zo laag mogelijk zijn.

- De WebCore Vitals in de Pagespeed Insights tool moeten ook worden geoptimaliseerd.

- Optimalisatie van LCP (Largest Content Paint).

- Optimalisatie van CLS (Cumulative Layout Shift). Tools zoals de Layout Shifter Generator helpen je om dergelijke fouten op te sporen.

- Een performante en gespecialiseerde WordPress hosting voor jouw WordPress projecten.

- Je website maakt idealiter gebruik van moderne technologieën zoals serverzijdige caching, compressie of ondersteunt moderne afbeeldingsformaten zoals webP om de laadtijd van een website te verkorten. Zie de tips hier onder "Prestaties en SEO".

- Als alternatief kan een plugin zoals WP Rocket worden gebruikt om de snelheid te optimaliseren of een cache te gebruiken (zie de tutorial over WP Rocket instellingen).

- Worden JavaScript en CSS bestanden gecomprimeerd?

- Je afbeeldingen worden ook gecomprimeerd en de afbeeldingsbreedte overschrijdt de maximumbreedte van de website niet.

- Je WordPress versie is up-to-date en je gebruikt een actuele versie van PHP.

- Je vermijdt te veel WordPress plugins en deactiveert degenen waarvan de functies niet worden gebruikt of kunnen worden opgelost zonder een plugin (zie http:// met https://).

Meer tips vind je in de volgende artikelen:

- Tips voor een performante Managed WordPress hosting

- WordPress hosting en website speed vergelijking

- E-Book: Webpage Speed correct meten

- PageSpeed Insights – Hoe optimaliseer jij je website?

Je backlink profiel

Backlinks zijn nog steeds een van de belangrijkste rankingfactoren in de Google zoekresultaten. Een hoogwaardige link naar je website is als een aanbeveling in het echte leven. Helaas kunnen wij niet filteren wie ons aanbeveelt en om welke redenen. En op het internet, waar veel processen geautomatiseerd of geanonimiseerd zijn, is niet elke "aanbeveling" een nuttige aanbeveling. Mogelijke redenen hiervoor kunnen zijn:

- Dit zijn gekochte backlinks van dubieuze bronnen

- Of een spam aanval met als doel je website te beschadigen.

- De verwijzende website wordt niet langer onderhouden en de informatie is verouderd

- De verwijzende website is verkocht of niet vernieuwd en is nu spam

Het is waar dat Google nu heel goed is in het beoordelen van de kwaliteit van een backlink. En welke komt van spam. Maar de systemen zijn nog niet perfect, zodat je soms "handmatig" moet helpen.

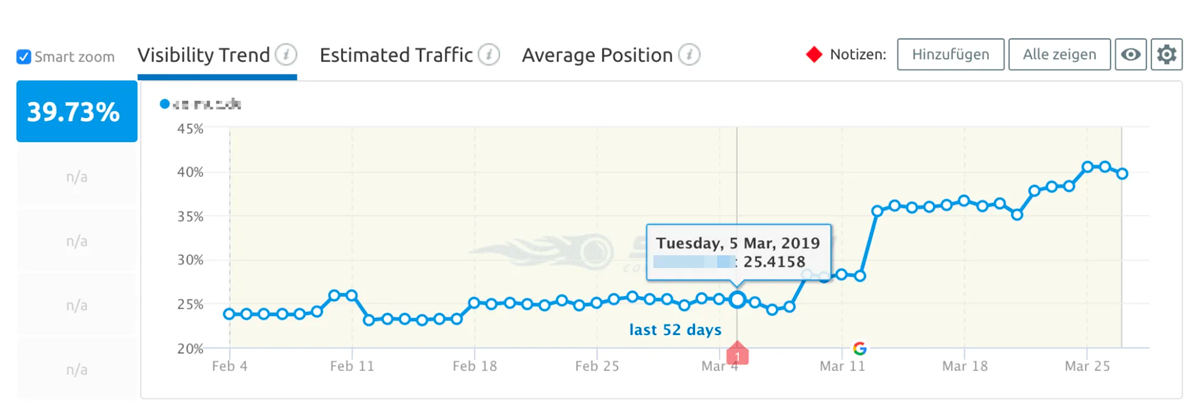

Gelukkig biedt Google met de Disavow tool een manier om schadelijke links permanent uit te sluiten van de berekening van je rankings. En zie, slechts enkele dagen nadat de Disavow-tool werd gebruikt, konden we al aanzienlijke successen boeken:

De illustratie toont de ranking van een klant nadat tienduizenden links van spamdomeinen waren "gedevalueerd" in de Disavow tool. Voor alle andere backlinks geldt: hoe hoger de kwaliteit van de bron en hoe passender de match met het onderwerp van je website, hoe beter de kwaliteit van een backlink. Zie ook deze tutorial van het Ahrefs-team. Het legt heel goed uit waar je op moet letten bij een backlink audit en hoe het kan worden uitgevoerd.

- Tools: Search Console, Majestic, Ahrefs, Semrush Link Audit

- Moeilijkheidsgraad: zeer moeilijk

Optie 1: Backlinks zoeken en manueel verwijderen

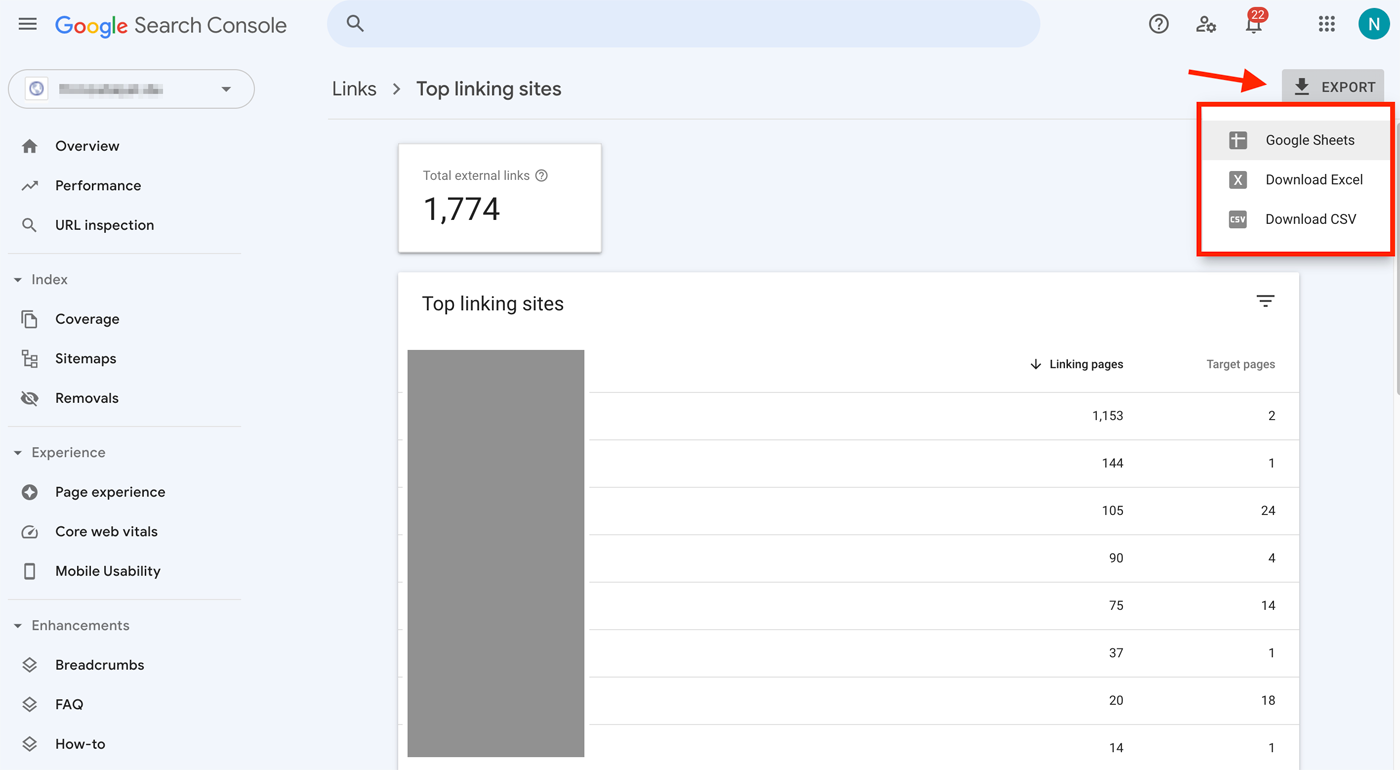

Om dit te doen, ga je naar de Google Search Console. Onder "Links" vind je de widget "Top verwijzende websites". Daar vind je een lijst van alle domeinen die naar je website linken:

In het overzicht van alle verwijzende domeinen, heb je de mogelijkheid om deze domeinen te exporteren naar een tabel. Van daaruit kun je elk afzonderlijk domein analyseren:

Het nadeel van deze methode is dat Search Console alleen de hoofddomeinen exporteert en niet de subpagina's van de verwijzende website. Je krijgt dus slechts een ruw overzicht van het backlinkprofiel.

Optie 2: Laat een SEO tool de backlinks analyseren

SEO tools zoals Semrush en Ahrefs bieden ook hulpmiddelen om de kwaliteit van de backlinks van je website te analyseren. Ahrefs geeft misschien wel de beste aanbevelingen van alle tools.

In Semrush vind je een overzicht van jouw backlinks onder het menu-item "Backlink Audit". Hier zie je het percentage backlinks dat afkomstig is van toxische (inferieure) bronnen. Het belangrijkste zijn de lijsten onder het tabblad "Audit".

Hier evalueert Semrush precies waarom een URL als giftig wordt beschouwd. Van daaruit kun je het markeren als "veilig" of de URL of het hele domein direct verplaatsen naar disavow.txt. Upload het dan naar Google.

Als je dit gedaan hebt, zou je een paar uur later via Search Console een melding moeten krijgen dat het disavow-bestand met succes is overgenomen. Vergeet niet om SEO tools volledige toegang te geven tot je Search Console en Analytics gegevens. Dit is de enige manier om een gedetailleerde lijst van al je backlinks te krijgen. Hier is een checklist:

- Heeft het domein waarnaar de link verwijst een thematische verwijzing naar mijn website?

- Is het domein waarnaar wordt gelinkt een spam-website (pornografische inhoud, oplichterij, fakewebsites)?

De meest gelinkte pagina's en gelinkte ankerteksten controleren

In de Search Console vind je het tabblad "Links". Daar zie je de widget Externe Links -> Meest Gelinkte Pagina's. Open dit rapport:

Nu kun je zien naar welke URL's op je website het meest wordt gelinkt door anderen. In de regel zal er het vaakst naar je startpagina "/" worden gelinkt. De eenvoudige reden hiervoor is dat mensen liever naar merken linken dan naar hele groepen woorden.

Wij analyseren nu echter het aantal links dat naar subpagina's verwijst. Dergelijke links zijn meestal een indicator van hoge kwaliteit en onderwerp-relevante referenties die Google en andere zoekmachines als bijzonder goed beoordelen. Kijk eens goed naar het volgende screenshot:

231 backlinks wijzen naar de startpagina "/", maar nauwelijks naar de belangrijke subpagina's. Er zijn helemaal geen backlinks naar de subpagina's van de diensten. Als zoekmachine-optimalisator zou ik nu het volgende concluderen:

- De kwaliteit van de subpagina's is slecht, dus andere mensen linken er niet naar. Er is geen stimulans.

- De diensten zijn tot nu toe niet gerankt omdat er geen thematische backlinks naar de subpagina's zijn.

Laten we tenslotte eens kijken naar de widget "Top linking text". Je kunt dit ook vinden in de Search Console onder "Links":

In het beste geval vind je een lijst met ankerteksten die verwijzen naar je domein, merk of de auteurs van je website. Deze natuurlijke links zijn essentieel voor zoekmachineoptimalisatie, aangezien vermeldingen op het web het vertrouwen bij zoekmachines bevorderen. Ze helpen om autoriteit rond je merk op te bouwen.

Onmiddellijk daarna moeten ankerteksten verschijnen met zoekwoorden die bijzonder belangrijk zijn voor je pagina. Bijvoorbeeld, diensten of producten. Uit de ankerteksten kunnen we aflezen dat belangrijke zoekwoorden momenteel nog ontbreken. Dit versterkt ook de veronderstelling dat de diensten nog geen backlinks hebben ontvangen. Bovendien zijn er ankerteksten van buitenlandse domeinen die op spam kunnen wijzen. Deze moeten nader worden onderzocht.

Traffic en rankings

Elke SEO audit heeft als doel het organische verkeer van je website op lange termijn te verhogen. Daarom zullen we in deze stap de huidige ranking van je website en het webverkeer uit Google Analytics onderzoeken.

Om dit te doen, ga je eerst naar Google Analytics. Een overzicht van de bezoekersaantallen van de laatste 12 maanden zie je in het menuonderdeel Doelgroep -> Overzicht. Deselecteer het segment "Alle gebruikers" en vervang het door "Organische bezoeken":

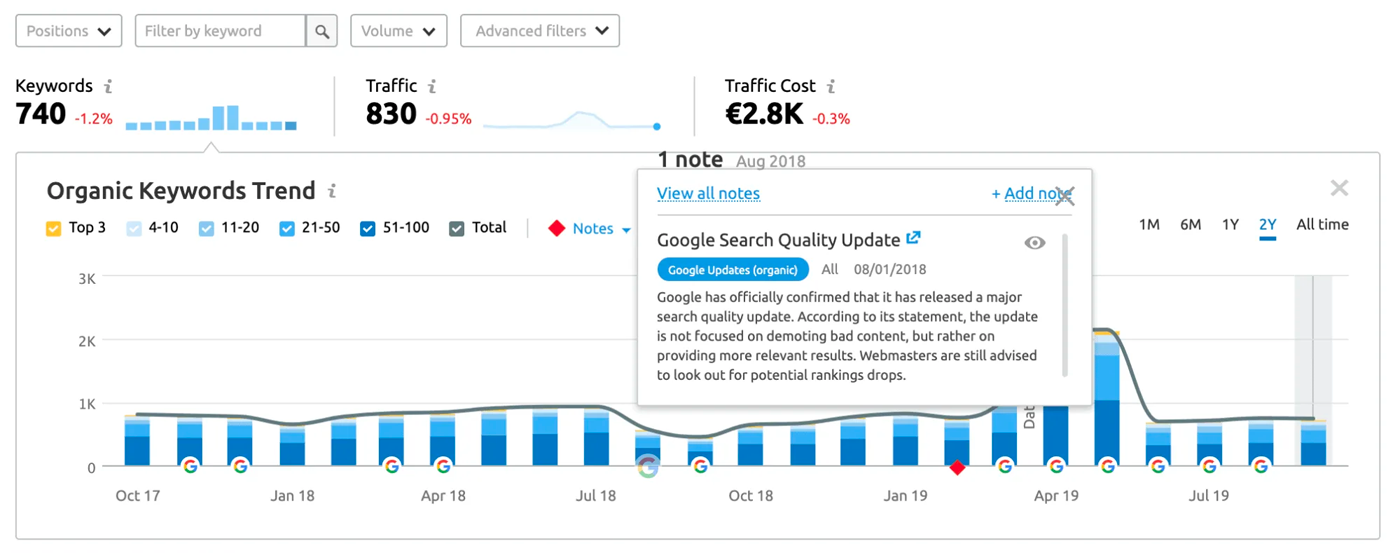

In het beste geval zou de ranking van je website voortdurend moeten stijgen. Als het verkeer op je website is gestagneerd of zelfs sterk is gedaald, dan moet je de redenen voor deze daling onderzoeken. Een oorzaak zou kunnen zijn dat deze website getroffen is door een Google update.

Helaas laat Google websitebeheerders niet weten of een update negatieve gevolgen voor hen heeft gehad. Het onderhoud en de controle is in handen van de webmasters. Je kunt echter op Google zoeken om er achter te komen of er updates en aankondigingen zijn in de betrokken periode:

En zie, grote SEO-magazines springen meteen in het oog en melden een update op 01 augustus 2018:

Nu weet je dat je website daadwerkelijk werd beïnvloed door een algoritme-update. Dit geeft je de kans om meer te weten te komen over de oorzaken en gevolgen. En je kunt informatie uitwisselen met de getroffenen om de ranking van je website te herstellen.

Als alternatief kun je de organische zoekfunctie van Semrush oproepen en daar een domein naar keuze invoeren. Bekende Google-updates worden ook in het diagram vermeld. Zij geven je een directe aanwijzing waarom de traffic op dat moment daalde:

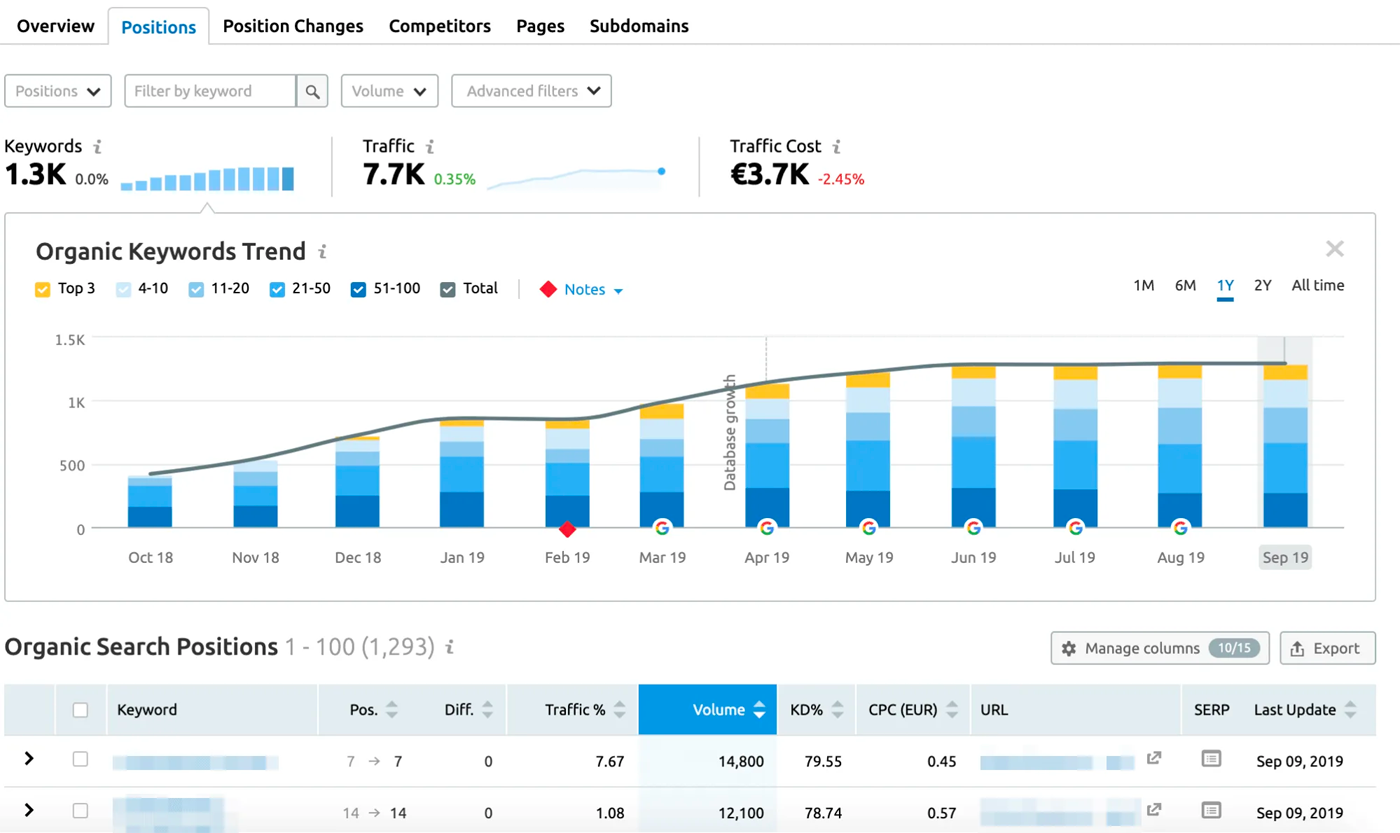

Helaas toont Analytics geen gegevens over de huidige keyword ranking van je website. Om dergelijke gegevens te verkrijgen, moet je een betaalde SEO tool of de Search Console gebruiken. Hoe groter de trefwoord database van de SEO tool, hoe beter je analyse zal zijn.

Om gegevens over de ranking van een website te verkrijgen, openen we opnieuw de organische zoekopdracht in Semrush. Het volgende voorbeeld toont aan dat alles tot nu toe correct is uitgevoerd. En dat de rankings van het domein steeds beter worden. We krijgen ook een overzicht van onze URL's: voor welk trefwoord of op welke positie staan zij?

Als je op een van de trefwoorden klikt, krijg je een lijst te zien met alle belangrijke gegevens voor deze zoekopdracht. Ook een lijst met de top-10-resultaten. Met andere woorden: je ziet je concurrentie.

Hier is het de taak van onze SEO audit om nieuwe trafficbronnen aan te boren en de huidige ranking te evalueren. Dit is de enige manier om trefwoordkansen te ontwikkelen en het websiteverkeer op lange termijn te verhogen. Analyseer wat je concurrenten die op je voorlopen, beter doen. Dit kan betere inhoud zijn, een betere tool of gewoon betere backlinks.

Om niet buiten het bestek van dit artikel te treden: in mijn artikel Met Keyword Research naar SEO succes vind je een complete gids voor het vinden van de belangrijkste zoekwoorden. Daar laat ik je stap voor stap zien hoe je met behulp van je huidige rankings zoekwoordenonderzoek kunt doen en nieuw verkeer kunt ontwikkelen.

Wat doe je als het webverkeer stagneert?

Jouw verkeer ontwikkelt zich niet meer omdat er geen nieuwe inhoud op de website wordt gepubliceerd, of omdat je website niet meer stijgt in de ranking. In dit geval raad ik ook een concurrentieanalyse aan voor elk keyword. Of om nieuwe trefwoorden te ontwikkelen door middel van een trefwoordenonderzoek.

Is het al een tijdje geleden dat het laatste artikel werd gepubliceerd? Dan is het ook raadzaam om alle inhoud te actualiseren.

Wat doe je als het verkeer ingezakt is?

Als je geen tekenen vindt dat je website werd beïnvloed door een Google-update, dan ligt een andere veronderstelling voor de hand: je website is het slachtoffer geworden van een technische fout. Volg alle veranderingen volgens het Reverse-engineer principe.

Controleer of er pagina's zijn gewijzigd of verwijderd in de weken voordat het verkeer instortte. Of heb je nieuwe WordPress plugins of een nieuw theme toegevoegd of updates doorgevoerd? Wat de reden ook is, je moet de oorzaak achterhalen door middel van het proces van eliminatie.

- Tools: Google Analytics, Matomo, Search Console

- Moeilijkheidsgraad: gemakkelijk – gemiddeld

Inhoud en tekstkwaliteit

Zoekmachines houden van verse inhoud! Het is niet voor niets dat het nu deel uitmaakt van elke SEO strategie om de inhoud op het internet regelmatig aan te passen en aan te vullen met nieuwe informatie. En je bezoekers zullen ook blij zijn met actuele bijdragen. Bekijk de tips in het e-book Doelgerichte Content Marketing.

Zo blijft ook de inhoud van je website actueel. En je vermindert het gevaar dat je concurrenten je met nieuwe inhoud om de eerste plaats uitdagen. Er is niets erger voor zoekmachines dan zoekers naar een website met verouderde inhoud te sturen. De taak van zoekmachines is immers de gebruikers de best mogelijke antwoorden te geven op hun zoekvragen. Als ze je website verlaten, is dat een slechte zaak voor de zoekmachine. En het is niet goed voor je gebruikerservaring. Met andere woorden, het heeft een negatieve invloed op je ranking.

Dit is precies de reden waarom je je inhoud regelmatig moet onderwerpen aan een content audit. Bij een content audit analyseer je alle content op je website om te zien of deze:

- Toegevoegde waarde bieden aan bezoekers

- Actuele inhoud bevatten

- Geen duplicaten van andere pagina's zijn

- Organisch verkeer laten zien

- Met andere pagina's gecombineerd kunnen worden

- Hoe de gebruikerservaring op deze URL wordt beïnvloed

Meestal maak je dan een lijst van alle URL's en bepaal je of een inhoud:

- Verwijderd is

- Samengevoegd is met een andere URL

- Bijgewerkt kan worden

- Of dat er geen handmatige actie nodig is

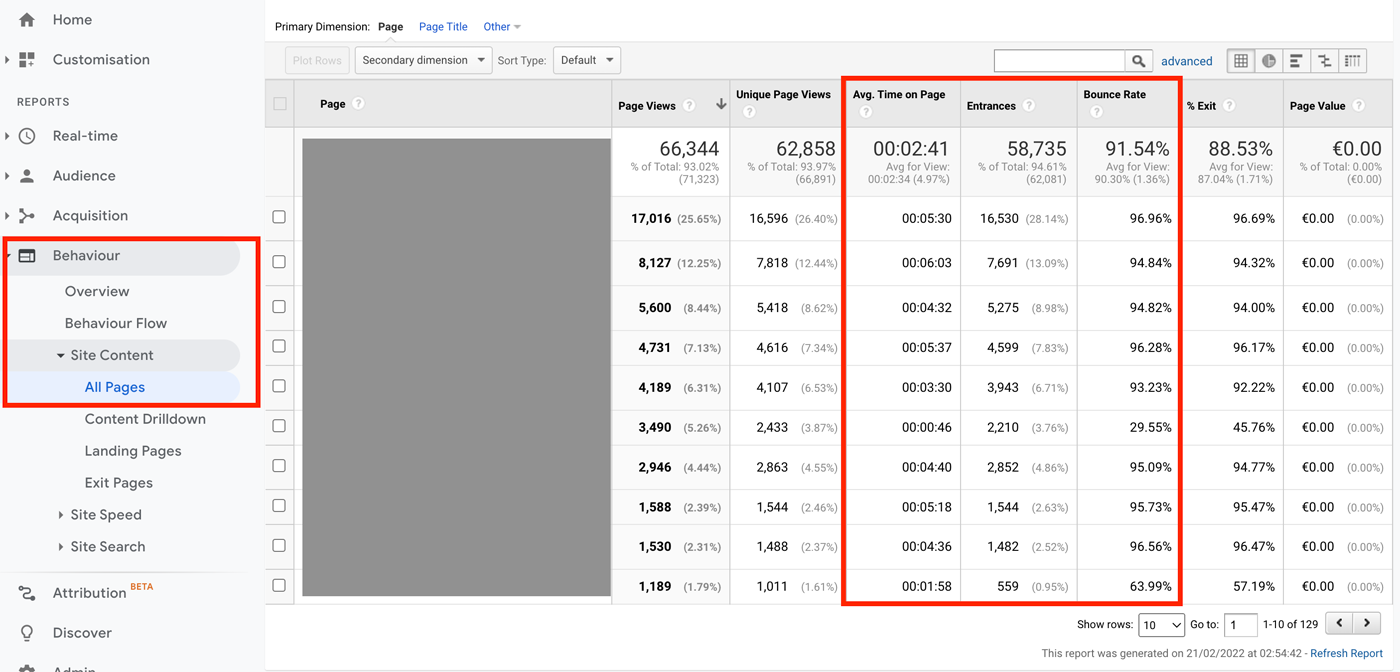

Je kunt gemakkelijk een inhoudsaudit bijhouden in een spreadsheet of Excel-tabel. Bovendien kun je elke URL afzonderlijk in Google Analytics onderzoeken op verblijfduur en bounce rates. De waarden geven aan of je bezoekers de inhoud van een website als nuttig of niet behulpzaam beoordelen.

Ga hiervoor naar het Google Analytics tabblad Gedrag -> Website-inhoud. Daar vind je een lijst van alle URL's en de meest bezochte pagina's:

Wil je meer weten over de Content Audit? Het boek "Think Content" van Miriam Löffler is hiervoor zeer geschikt. Het bevat talloze tips over contentmarketing en de juiste contentstrategie.

Vergeet metatitels en metabeschrijvingen niet

Tijdens een content audit richten veel webmasters zich alleen op de oppervlakkig zichtbare inhoud van hun webpagina's. Ze vergeten vaak ook hun metabeschrijvingen en metatitels aan te passen. Dit zijn de korte teksten die later in de zoekresultaten worden weergegeven. Ze moeten gebruikers aanmoedigen om op je resultaat te klikken.

Om de meta-informatie van je webpagina's te controleren: ga naar de Google-zoekopdracht op en voer het commando "site:jouwdomein.xyz" in het zoekmasker in. Je krijgt dan een lijst van al je geïndexeerde pagina's. Je kunt hier zien welke metabeschrijvingen en metatitels te lang of te kort zijn.

Click Through Rate optimaliseren

Presenteer de inhoud van je pagina's altijd op een informatieve manier. Zorg er tegelijkertijd voor dat je zoekresultaten zo aantrekkelijk en spannend mogelijk zijn voor gebruikers. Meta-informatie is niet langer een actieve rankingfactor. Het aantal mensen dat op je resultaat klikt, kan echter nog steeds een passief effect hebben op je positionering. Het sleutelwoord is de click through rate (CTR).

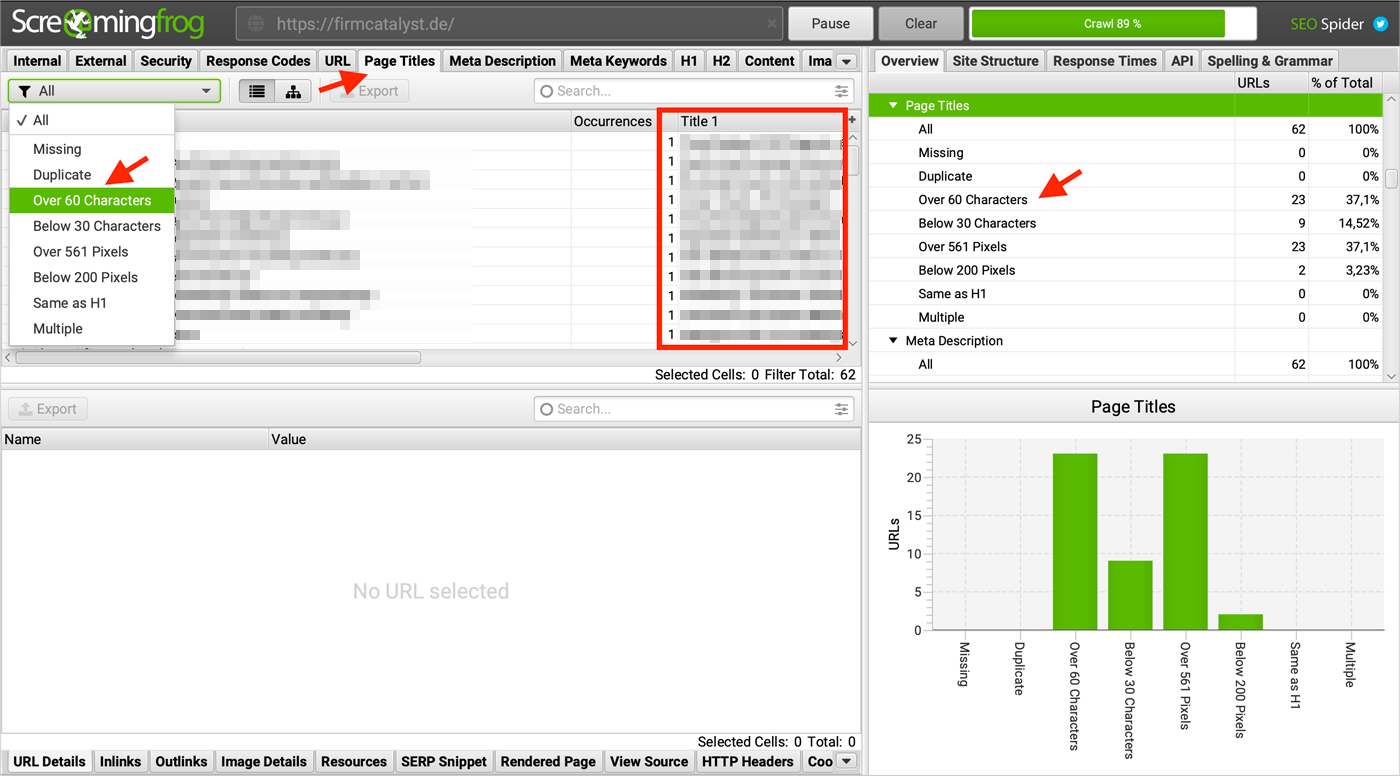

Of gebruik een tools zoals de Screaming Frog Spider. Het crawlt alle URL's van je website en laat zien of metabeschrijvingen te lang zijn of zelfs ontbreken:

Met een plugin als Yoast SEO kan de meta-informatie van een URL rechtstreeks in de WordPress editor bewerkt worden. De plugin laat je ook zien of je je hebt gehouden aan de karakterlimieten die gelden voor de metatitel of metabeschrijving. Voor de inhoud gelden de volgende criteria:

- Elke subpagina heeft slechts één H1 tag. Deze tag is kort, bondig en beschrijft duidelijk het onderwerp van de webpagina. Als je er meerdere hebt, moet je dit veranderen.

- De inhoud is in verdere themarelevante rubrieken onderverdeeld.

- De inhoud is uniek en staat niet dubbel op de website.

- Hebben alle pagina's een aansprekende meta title? Vermijd duplicaten.

- Hebben alle pagina's een aansprekende meta description? Vermijd ook hier verdubbelingen.

- Is alle inhoud op je website uniek en van hoge kwaliteit?

- Wijzen alle interne en externe links naar geldige websites?

- Alle teksten voldoen aan de zoekintentie van de gebruikers.

- Belangrijk voor zoekmachineoptimalisatie: Teksten linken naar andere subpagina's.

- Teksten bevatten een auteursbox en voldoen aan de richtlijnen van YMYL en EAT als je pagina's bij een gevoelig themagebied horen (recht, financiën, geneeskunde).

- URL's hebben minder dan 300 woorden. Webpagina's met weinig inhoud zijn meestal een indicator van slecht onderzoek ("dunne inhoud") of slechte kwaliteit, zodat de vraag of zoekintentie van de gebruiker niet wordt beantwoord.

- Links in de main content hebben beschrijvende tekst.

- Zijn alle afbeeldingen op je website toegankelijk en geven ze geen 404-foutmelding?

- Elke afbeelding heeft ook een beschrijvend ALT-attribuut. Dit is belangrijk voor zoekmachines om de inhoud van een afbeelding te begrijpen, maar ook voor een toegankelijke website.

De verhouding tussen tekst en HTML mag ook niet minder dan 10 procent zijn. Iets anders kan duiden op overbelaste code, veroorzaakt door bijvoorbeeld WordPress Page Builders.

De lokale SEO audit

Een lokale SEO audit is de optimalisatie van lokale subpagina's, de optimalisatie van je Google Mijn Bedrijf vermelding en de vermelding in bedrijvengidsen. Een lokale SEO audit is eenvoudig (maar tijdrovend) om uit te voeren, aangezien externe bronnen voornamelijk worden gecontroleerd om te zien of ze overeenkomen met de geoptimaliseerde Google My Business Listing. Het wordt nog ingewikkelder als je bedrijf in het verleden van locatie is veranderd.

Zorg ervoor dat de bedrijfsnaam hetzelfde is. Als het bijvoorbeeld "Natuurgeneeskunde Zwolle" is, dan moet dat ook zo zijn op de website en in alle gidsen, inclusief bedrijfsgegevens. Bedrijven gebruiken echter vaak aliassen zoals "Anja Voorbeeld Natuurgeneeskundige", wat tot verwarring kan leiden in de zoekresultaten.

Een echte aanrader is de blog van het webbureau Whitespark, dat zeer gedetailleerde tutorials (PDF) en case studies publiceert over het optimaliseren van je lokale resultaten.

- Tools:Google Mijn Bedrijf, Whitespark,Yext (voor Duitssprekende landen)

- Moeilijkheidsgraad: gemakkelijk

Vragen die je jezelf moet stellen bij het lokaal optimaliseren:

- Bestaat de juiste Google My Business vermelding voor elke locatie?

- Zijn de gegevens voor elke locatie in Google Mijn Bedrijf up-to-date?

- Zijn de juiste bedrijfscategorieën geselecteerd op Google Maps?

- Heeft de Google My Business vermelding voldoende foto's of video's van hoge kwaliteit?

- Is je bedrijf opgenomen in de belangrijkste Nederlandse bedrijvengidsen?

- Zijn de bedrijfsgegevens in elke ondernemersgids bijgewerkt?

- Is de informatie in elke bedrijvengids ook relevant?

- Link building interface: als je diensten of producten alleen in deze regio worden aangeboden, zijn er dan ook backlinks uit de regio die belangrijk zijn voor de lokale rankings? Bijvoorbeeld van plaatselijke kranten, vermeldingen of samenwerkingsverbanden?

Nauwelijks relevant voor rankings in lokale zoekresultaten zijn:

- Google Mijn Bedrijf berichten / lokale berichten

- Beschikbaarheid voor vragen of een chatfunctie

- Keyword stuffing in de bedrijfsnaam (mogelijk zelfs tegen de Google My Business richtlijnen).

Opeenvolging van maatregelen

Dat zijn veel aanbevelingen, maar waar moet je beginnen? Niet alle eerder genoemde – eerder algemene aanbevelingen – zullen een grote impact hebben op de positionering van je website. Soms is het slechts een klein aantal problemen dat een subpagina verhindert te scoren. SEO-experts zijn meer ervaren in het beoordelen van de kosten en baten van een aanbeveling.

Belangrijk is dat je er altijd van bewust bent dat ej WordPress website nooit een 100/100 score hoeft te behalen. Overoptimalisering leidt tot meer kosten dan werkelijke, duurzame baten. Al was het maar omdat regels, aanbevelingen en de weging daarvan op elk moment kunnen veranderen.

Om het meeste uit je zoekmachine optimalisatie te halen, zelfs als beginner, adviseer ik de volgende volgorde van verwerking:

1. Waarschuwingen in de Search Console oplossen

Google – als de rechter van succes – waarschuwt je al voor kritieke fouten in zijn eigen tool, de Search Console. Daarom moet je deze waarschuwingen zeker opvolgen.

2. Globale in plaats van minimale veranderingen

In plaats van je te concentreren op het optimaliseren van één enkele URL, moet je je in eerste instantie richten op die taken die automatisch effect hebben op alle URL's. Met andere woorden, op je hele website.

Als je de snelheid van alle subpagina's in één klap verbetert, bijvoorbeeld door alle afbeeldingen te comprimeren, zal dit een groot effect hebben op het succes van je project. De eerste successen van dergelijke optimalisaties motiveren je om de zaak intensiever aan te pakken.

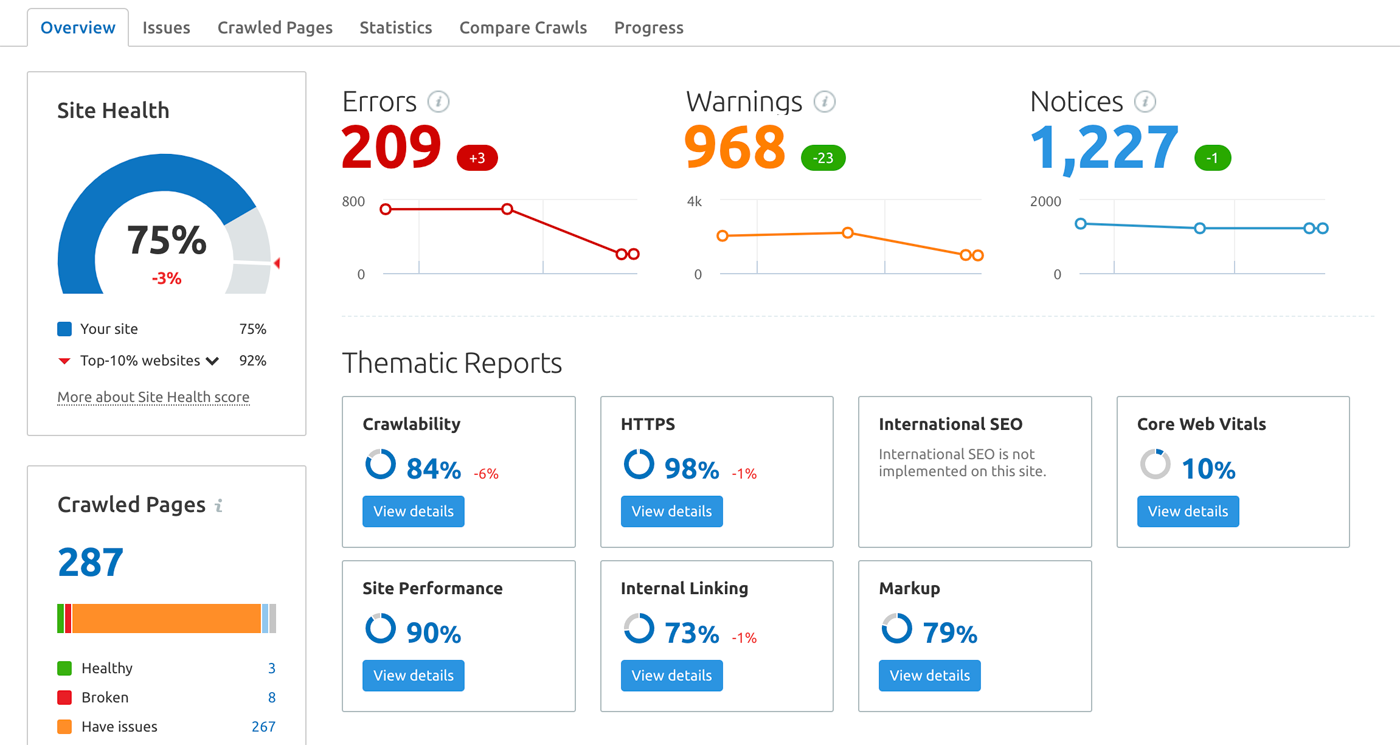

3. Kritieke fouten in audit tools

De meeste tools voor een SEO audit categoriseren de gevonden fouten naar hoe ernstig ze zijn. Hier is een voorbeeld van de tool Semrush:

Ga als volgt te werk om de fouten te corrigeren:

- Kritieke fouten moeten in ieder geval worden gecorrigeerd. Zij beïnvloeden de rankings van je website het meest en kunnen negatieve gevolgen hebben.

- Gemiddelde fouten hebben een minder ingrijpend effect dan kritieke fouten. Ze hebben ofwel een passief effect op de ranking van je website, of ze beïnvloeden de user experience. Dit heeft op zijn beurt gevolgen voor de ranking van je website.

- Je moet ook op de aanwijzingen letten, zelfs als ze niet als problemen worden genoemd.

In het laatste geval krijg je aanbevelingen voor actie in Semrush waarvan de tool niet precies kan beoordelen of de gemaakte instellingen ook werkelijk bedoeld zijn. Een voorbeeld: moet een bepaalde pagina echt als noindex gemarkeerd worden?

4. De inhoud blijft het belangrijkste criterium voor je ranking

Zoals voorheen kan aan het motto "Content is King" de hoogste waarde worden toegekend. Zelfs de meest geoptimaliseerde website met de beste backlinks heeft geen nut als je inhoud slecht is. Als de bovenstaande aanbevelingen geen succes hebben, dan moet je je optimalisatie-inspanningen richten op de inhoud van je website. Want goede inhoud blijft de belangrijkste rankingfactor in de organische zoekresultaten.

Liefdeloze stockfoto's en gekopieerde teksten van verschillende auteursplatforms kunnen uiteindelijk het verschil zijn tussen jouw inhoud die zich bewijst tegenover de concurrentie. Of, zoals Google zelf uitlegt in deze YouTube-video: "Create great content that performs well in Google search results".

Denk je dat je aan al deze eisen hebt voldaan? Dan is het zinvol om je in te lezen over specifieke optimaliseringsmaatregelen, zoals linkbuilding.

Conclusie: Regelmaat leidt naar het doel

Elk jaar worden er duizenden wijzigingen aangebracht in het zoekalgoritme, waarbij op gezette tijden kleine aanpassingen worden doorgevoerd. Er worden steeds nieuwe functies toegevoegd aan de zoekresultaten van Google en andere zoekmachines. Maar de basisregels van zoekmachine-optimalisatie blijven meestal dezelfde.

Je veranderingen moeten altijd gericht zijn op het verbeteren van de gebruikerservaring. Een SEO-audit helpt je daarbij. Het is daarom raadzaam om minstens één keer per jaar zo'n audit uit te voeren. Vond je deze gids leuk? Download hem dan hier als PDF en deel hem met anderen.

Jouw vragen over de SEO audit

Welke vragen heb je voor Dominik over de SEO audit? Voel je vrij om de commentaarfunctie te gebruiken. Wil je op de hoogte blijven van nieuwe artikelen over het onderwerp online marketing? Volg ons dan op Twitter, Facebook, LinkedIn of via onze nieuwsbrief.